🐳 集成学习相关代码和博文整理 🐳

1、Tree + boost GitHub

2、GBM(Gradient Boosting Machine)

GBM 理解,该博客中的公式色系和注释非常便于辅助理解。

- 三种损失函数,square loss,absolute loss,huber loss。

- AdaBoost 采用 square loss,GBDT 采用后面两种损失函数之一。

3、Tree 系列一

主要介绍ID3、C4.5、CART。

4、Tree 系列二

主要介绍Random Forest、Adaboost、GBDT。

- 集成学习三大类,Bagging(RF),Boosting(GBDT) 和 Stacking。

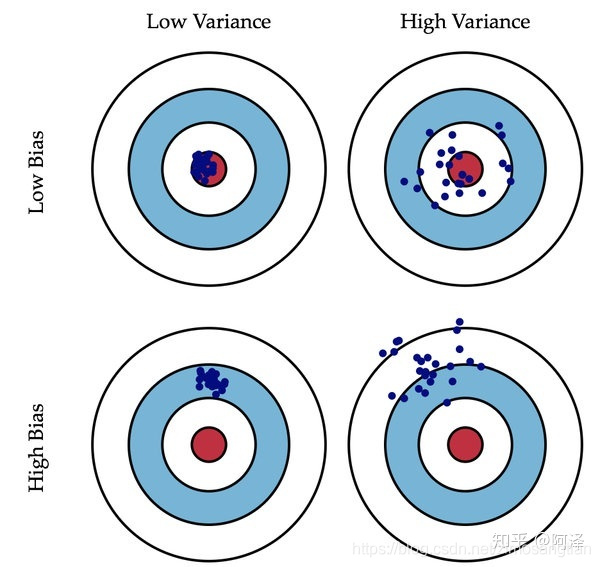

- 偏差(Bias)描述的是预测值和真实值之差;方差(Variance)描述的是预测值作为随机变量的离散程度。如下图所示。

5、Tree 系列三

主要介绍XGBoost、LightGBM。

- 直方图算法可以显著降低内存消耗。

6、LightGBM 安装教程

参考LightGBM 教程。

- 辅助理解 LightGBM 中的直方图算法等。

- 安装命令,pip install lightgbm。

参考LightGBM 调参。

- sklearn 中 GBDT 和 LightGBM 的参数介绍。